مهندسی زمینه: یک رشته در حال تحول در مدلهای زبان بزرگ (LLMs)

مقاله “بررسی مهندسی زمینه برای مدلهای زبان بزرگ” به طور رسمی مهندسی زمینه را به عنوان یک رشته تخصصی معرفی میکند که فراتر از مهندسی پرامپت است. این رشته یک چارچوب یکپارچه و سیستماتیک برای طراحی، بهینهسازی و مدیریت اطلاعاتی که به مدلهای زبان بزرگ (LLMs) وارد میشود، فراهم میآورد تا عملکرد آنها را در زمینههای درک، استدلال، سازگاری و کاربردهای دنیای واقعی به حداکثر برساند.

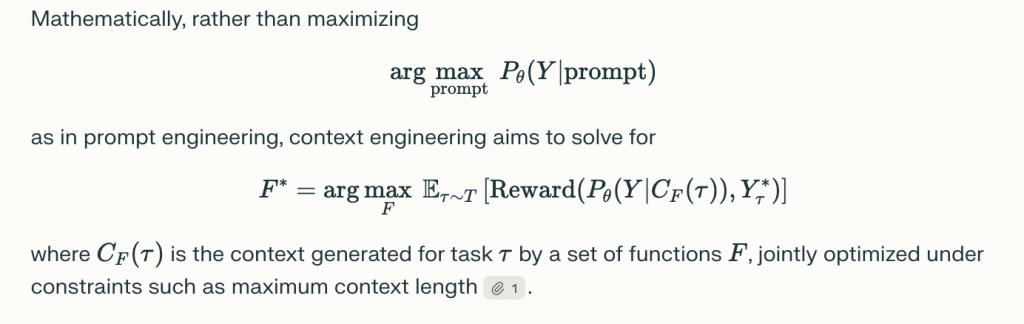

در حالی که مهندسی پرامپت (Prompt Engineering) معمولاً بر تنظیم دقیق دستورالعملها و ورودیهای متنی برای دستیابی به خروجیهای مطلوب تمرکز دارد، مهندسی زمینه دیدگاهی بسیار جامعتر را ارائه میدهد. این رویکرد به جای در نظر گرفتن زمینه به عنوان یک رشته متنی ثابت، آن را به عنوان مجموعهای پویا و ساختارمند از مؤلفهها میبیند. هر یک از این مؤلفهها به شیوهای خاص استخراج، انتخاب و سازماندهی میشوند، که اغلب تحت محدودیتهای سختگیرانه منابع و معماری صورت میگیرد.

این تمایز اساسی به مهندسی زمینه این امکان را میدهد که به چالشهای پیچیدهتری در تعامل با LLMها بپردازد. این نه تنها شامل چگونگی ساختاردهی پرامپتها میشود، بلکه شامل منابع اطلاعاتی خارجی، مدیریت حافظه مدل، و حتی چگونگی تعامل مدل با ابزارهای بیرونی را نیز در بر میگیرد. با این دیدگاه گسترده، مهندسی زمینه به دنبال افزایش کارایی و قابلیت اطمینان LLMها در سناریوهای پیچیده و متنوع است.

تصور کنید که یک LLM باید به سوالات بسیار تخصصی در یک حوزه خاص پاسخ دهد. مهندسی زمینه نه تنها نحوه طرح سوال را بهینه میکند، بلکه منابع دانش مرتبط (مانند پایگاه دادهها یا اسناد تخصصی) را بازیابی کرده، آنها را فشردهسازی میکند تا در محدودیت طول زمینه مدل جای بگیرند، و سپس اطلاعات را به شکلی سازماندهی میکند که مدل بتواند بهترین استدلال را از آن استخراج کند. این رویکرد چندوجهی، LLM را قادر میسازد تا از ظرفیتهای بالقوه خود به بهترین شکل استفاده کند.

واکاوی مهندسی زمینه: یک طبقهبندی جامع

این مقاله مهندسی زمینه را به دو بخش اصلی تقسیم میکند: مولفههای بنیادی و پیادهسازیهای سیستمی. این تقسیمبندی به ما کمک میکند تا پیچیدگیهای این رشته را به صورت ساختارمندتر درک کنیم و به جزئیات هر یک از ابعاد آن بپردازیم.

1. مؤلفههای بنیادی

الف. بازیابی و تولید زمینه (Context Retrieval and Generation)

این بخش شامل جنبههای مختلفی است که از مهندسی پرامپت آغاز شده و به سمت روشهای پیشرفتهتر حرکت میکند. مهندسی پرامپت، به عنوان نقطه شروع، بر طراحی و بهینهسازی ورودیهای متنی تمرکز دارد تا مدل بتواند پاسخهای دقیق و مرتبط تولید کند. این شامل انتخاب کلمات، ساختار جملات و تنظیمات خاص برای پرامپتها است که تأثیر مستقیمی بر کیفیت خروجی مدل دارد.

یادگیری درونزمینهای (In-context Learning)، که شامل روشهایی مانند یادگیری صفر-شات (Zero-shot)، چند-شات (Few-shot)، زنجیره فکری (Chain-of-Thought)، درخت فکری (Tree-of-Thought)، و گراف فکری (Graph-of-Thought) میشود، به مدل این امکان را میدهد که بدون نیاز به تنظیمات مجدد (fine-tuning) بر روی دادههای جدید، از مثالها و الگوهای موجود در زمینه برای انجام وظایف جدید استفاده کند. این تکنیکها، به ویژه زنجیره فکری، به مدل کمک میکنند تا مراحل استدلالی خود را آشکار سازد و به این ترتیب، قابلیت توضیحپذیری و دقت پاسخها افزایش مییابد.

بازیابی دانش خارجی (External Knowledge Retrieval) یکی دیگر از جنبههای حیاتی است که در آن مدلها به منابع دانش بیرونی مانند پایگاه دادههای برداری، گرافهای دانش یا اسناد متنی دسترسی پیدا میکنند. این فرآیند، که اغلب با استفاده از معماریهای بازیابی-افزایشیافته تولید (Retrieval-Augmented Generation – RAG) صورت میگیرد، به مدل امکان میدهد تا اطلاعات بهروز و دقیق را از منابع خارج از دادههای آموزشی خود بازیابی کرده و در پاسخهایش لحاظ کند. این امر به ویژه برای وظایفی که نیاز به دانش تخصصی یا اطلاعات لحظهای دارند، بسیار مهم است.

تکنیکهای پیشرفتهای مانند چارچوب CLEAR و مونتاژ دینامیک الگوها (Dynamic Template Assembly) برای سازماندهی و ترکیب پویا اجزای زمینه به کار میروند. این روشها به مدل اجازه میدهند تا زمینه را بر اساس نیازهای خاص هر پرسش یا وظیفه، به صورت منعطف و بهینه ساختاردهی کند. معماریهای بازیابی مدولار نیز در این زمینه نقش دارند و امکان ادغام چندین منبع دانش و استراتژی بازیابی را فراهم میآورند.

ب. پردازش زمینه (Context Processing)

پردازش زمینه شامل تکنیکهایی است که برای مدیریت و بهینهسازی دنبالههای طولانی اطلاعات به کار میروند، زیرا مدلهای زبان بزرگ با افزایش طول زمینه ورودی، با چالشهای محاسباتی و عملکردی مواجه میشوند. پردازش دنبالههای طولانی (Long-sequence Processing) با استفاده از معماریهایی مانند Mamba، LongNet و FlashAttention، به مدلها امکان میدهد تا با ورودیهای بسیار بلندتر به طور موثرتری کار کنند. این معماریها به کاهش پیچیدگی محاسباتی توجه (attention) در ترانسفورمرها کمک میکنند و امکان پردازش حجم عظیمی از دادهها را فراهم میآورند.

خود-بهینهسازی زمینه (Context Self-refinement) فرآیندی است که در آن مدل به صورت مکرر پاسخهای خود را ارزیابی و بهبود میبخشد. این شامل حلقههای بازخورد تکراری و مکانیسمهای خود-ارزیابی است که به مدل اجازه میدهد تا خطاهای خود را تشخیص داده و تصحیح کند، در نتیجه کیفیت خروجیها به طور مداوم افزایش مییابد. این فرآیند میتواند به صورت خودکار یا با نظارت انسانی انجام شود و برای دستیابی به دقت بالا در وظایف پیچیده ضروری است.

ادغام اطلاعات چندوجهی و ساختارمند (Integration of Multimodal and Structured Information) نیز یکی از ابعاد مهم پردازش زمینه است. LLMها اکنون قادرند نه تنها متن، بلکه تصاویر، صدا، گرافها و جداول را نیز درک و پردازش کنند. این قابلیت چندوجهی، مدلها را قادر میسازد تا در سناریوهای دنیای واقعی که اطلاعات در فرمتهای مختلفی ارائه میشوند، عملکرد بهتری داشته باشند. استراتژیهایی مانند توجه پراکنده (attention sparsity) و فشردهسازی حافظه (memory compression) نیز برای مدیریت کارآمد منابع در هنگام پردازش اطلاعات پیچیده استفاده میشوند.

ج. مدیریت زمینه (Context Management)

مدیریت زمینه به چگونگی سازماندهی و ذخیرهسازی اطلاعات برای دسترسی بهینه در طول زمان میپردازد. این شامل سلسلهمراتب حافظه و معماریهای ذخیرهسازی است که مدلهای زبان بزرگ از آنها برای نگهداری اطلاعات استفاده میکنند. پنجرههای زمینه کوتاهمدت (short-term context windows) اطلاعات فوری را در خود نگه میدارند، در حالی که حافظه بلندمدت (long-term memory) و پایگاههای داده خارجی (مانند پایگاههای داده برداری) به مدل اجازه میدهند تا اطلاعات را برای مدتهای طولانیتر و در مقیاس بزرگتر ذخیره و بازیابی کند.

صفحهبندی حافظه (memory paging) و فشردهسازی زمینه (context compression) با استفاده از تکنیکهایی مانند خودرمزگذارها (autoencoders) و فشردهسازی بازگشتی (recurrent compression)، به مدلها کمک میکنند تا با محدودیتهای حافظه مقابله کنند و همچنان به حجم زیادی از اطلاعات دسترسی داشته باشند. این مکانیسمها برای حفظ کارایی و مقیاسپذیری مدل در هنگام کار با دادههای وسیع حیاتی هستند. مدیریت مقیاسپذیر زمینه در تنظیمات چند-دور (multi-turn) یا چند-عاملی (multi-agent) نیز از اهمیت بالایی برخوردار است، جایی که مدل باید اطلاعات را به طور پیوسته در طول مکالمات طولانی یا تعاملات پیچیده بین عوامل مختلف مدیریت کند.

استفاده از پایگاههای داده برداری خارجی به مدلها اجازه میدهد تا بدون نیاز به بارگذاری تمام دانش در حافظه خود، اطلاعات مرتبط را بر اساس شباهت معنایی بازیابی کنند. این امر به خصوص در سناریوهای RAG مفید است، جایی که مدل نیاز به دسترسی به دهها هزار یا میلیونها سند برای پاسخ به سوالات دارد. این سیستمها قابلیت مدل را در پاسخگویی به سوالات پیچیده و ارائه اطلاعات دقیق و بهروز به طور چشمگیری افزایش میدهند.

2. پیادهسازیهای سیستمی (System Implementations)

پیادهسازیهای سیستمی نشان میدهند که چگونه مؤلفههای بنیادی مهندسی زمینه در سیستمهای LLM کاربردی به کار گرفته میشوند تا قابلیتهای آنها را در دنیای واقعی گسترش دهند.

الف. تولید با کمک بازیابی (Retrieval-Augmented Generation – RAG)

معماریهای RAG، چه مدولار، چه مبتنی بر عامل (agentic) و چه تقویتشده با گراف، برای ادغام دانش خارجی با تواناییهای تولید LLM ضروری هستند. این سیستمها به مدل اجازه میدهند تا اطلاعات را به صورت پویا از منابع خارجی بازیابی کرده و آنها را در پاسخهای خود ترکیب کند. این کار نه تنها دقت را افزایش میدهد بلکه امکان بهروزرسانی دانش مدل را بدون نیاز به آموزش مجدد کامل فراهم میکند. معماریهای RAG مبتنی بر عامل، قادر به اجرای خطوط لوله بازیابی پیچیده هستند که شامل چندین مرحله پرسوجو و ترکیب اطلاعات از منابع متنوع است.

توانایی RAG در ترکیب اطلاعات لحظهای از پایگاه دادهها یا گرافهای دانش با قابلیتهای استدلالی LLM، آن را به ابزاری قدرتمند برای وظایفی مانند پاسخگویی به سؤالات تخصصی در زمان واقعی یا خلاصهسازی اسناد پیچیده تبدیل کرده است. این سیستمها به LLM امکان میدهند تا به اطلاعاتی دسترسی پیدا کند که در دادههای آموزشی اصلی آن وجود ندارد، بنابراین کاربردپذیری آن را به طور چشمگیری گسترش میدهد.

ب. سیستمهای حافظه (Memory Systems)

سیستمهای حافظه، ذخیرهسازی پایدار و سلسلهمراتبی اطلاعات را برای LLMها فراهم میکنند که امکان یادگیری طولانیمدت (longitudinal learning) و بازیابی دانش را برای عوامل هوشمند فراهم میآورد. این سیستمها، مانند MemGPT و MemoryBank، به LLMها اجازه میدهند تا مکالمات گذشته، ترجیحات کاربر و اطلاعات محیطی را به خاطر بسپارند و در طول تعاملات متعدد به آنها دسترسی داشته باشند. استفاده از پایگاه دادههای برداری خارجی به عنوان حافظه بلندمدت نیز این قابلیت را تقویت میکند.

این قابلیت برای دستیاران شخصیسازیشده، عوامل هوشمند در شبیهسازیها و سیستمهای مکالمهای چند-دور که نیاز به حفظ زمینه در طول زمان دارند، بسیار حیاتی است. سیستمهای حافظه به LLMها کمک میکنند تا رفتارها و پاسخهای خود را با توجه به تاریخچه تعاملات پیشین تطبیق دهند، که منجر به تجربههای کاربری طبیعیتر و کارآمدتر میشود.

ج. استدلال یکپارچه با ابزار (Tool-Integrated Reasoning)

این قابلیت به LLMها اجازه میدهد تا از ابزارهای خارجی (مانند APIها، موتورهای جستجو و ابزارهای اجرای کد) برای انجام وظایف پیچیده استفاده کنند. این امر با استفاده از فراخوانی توابع (function calling) یا تعامل با محیطهای خارجی صورت میگیرد. به عنوان مثال، یک LLM میتواند از یک API هواشناسی برای بازیابی اطلاعات آبوهوا استفاده کند یا از یک ابزار اجرای کد برای حل مسائل ریاضی یا برنامهنویسی بهره ببرد. این ادغام، تواناییهای استدلالی LLM را با قابلیتهای عملی دنیای واقعی ترکیب میکند و به آن امکان میدهد تا در حوزههای جدیدی مانند ریاضیات، برنامهنویسی، تعامل با وب و تحقیقات علمی فعالیت کند.

این رویکرد به LLMها اجازه میدهد تا بر محدودیتهای دانش خود غلبه کرده و به اطلاعات و قابلیتهای فراتر از دادههای آموزشی خود دسترسی پیدا کنند. این امر به خصوص در سناریوهایی که نیاز به محاسبات دقیق، دسترسی به دادههای لحظهای یا اجرای اقدامات در دنیای دیجیتال دارند، بسیار ارزشمند است. استدلال یکپارچه با ابزار، LLMها را به عوامل هوشمند و چندکارهای تبدیل میکند که میتوانند طیف وسیعی از مسائل را حل کنند.

د. سیستمهای چند-عاملی (Multi-Agent Systems)

سیستمهای چند-عاملی شامل هماهنگی و همکاری بین چندین LLM (عامل) برای حل مسائل پیچیده است. این عاملها از طریق پروتکلهای استاندارد، هماهنگکنندهها (orchestrators) و به اشتراکگذاری زمینه با یکدیگر تعامل میکنند. این رویکرد برای وظایفی که نیاز به تقسیم کار، تخصصهای مختلف و حل مشارکتی مسائل دارند، ضروری است. به عنوان مثال، در یک سیستم چند-عاملی، یک عامل ممکن است مسئول جمعآوری اطلاعات باشد، در حالی که دیگری بر استدلال و تحلیل تمرکز میکند و عامل سوم مسئول تولید پاسخ نهایی است.

سیستمهای چند-عاملی در کاربردهای پیچیده مانند شبیهسازیهای علمی، طراحی مهندسی و حل مسائل استراتژیک در کسبوکار کاربرد دارند. این سیستمها به طور فزایندهای برای دستیابی به قابلیتهای هوش مصنوعی توزیعشده و بهبود کارایی در حل مسائل مقیاسپذیر مورد توجه قرار گرفتهاند. همکاری بین عوامل، امکان رسیدگی به پیچیدگیهایی را فراهم میکند که یک LLM منفرد قادر به مدیریت آنها نیست.

نکات کلیدی و شکافهای تحقیقاتی

بر اساس بررسی انجام شده در مقاله، مهندسی زمینه پیشرفتهای چشمگیری در تواناییهای LLMها ایجاد کرده است، اما همچنان چالشها و شکافهای تحقیقاتی مهمی وجود دارد که نیازمند توجه هستند:

- عدم تقارن درک و تولید (Comprehension–Generation Asymmetry): LLMها، حتی با پیشرفتهترین تکنیکهای مهندسی زمینه، قادر به درک زمینههای بسیار پیچیده و چندوجهی هستند، اما هنوز در تولید خروجیهایی که با همان سطح پیچیدگی یا طول مطابقت داشته باشند، دچار مشکل میشوند. این عدم تقارن نشان میدهد که درک مدل لزوماً به معنای توانایی تولید متنی با کیفیت یکسان نیست و نیاز به تحقیقات بیشتر در این زمینه وجود دارد.

- یکپارچهسازی و مدولار بودن (Integration and Modularity): بهترین عملکرد در LLMها زمانی حاصل میشود که معماریهای مدولار، چندین تکنیک مهندسی زمینه (مانند بازیابی، مدیریت حافظه و استفاده از ابزار) را با هم ترکیب کنند. این رویکرد نشان میدهد که هیچ راهحل واحدی برای تمام مشکلات وجود ندارد و ترکیب هوشمندانه ابزارها و روشها ضروری است.

- محدودیتهای ارزیابی (Evaluation Limitations): معیارهای ارزیابی فعلی (مانند BLEU و ROUGE) اغلب نمیتوانند رفتارهای ترکیبی، چندمرحلهای و مشارکتی که توسط مهندسی زمینه پیشرفته امکانپذیر میشود را به درستی اندازهگیری کنند. نیاز به معیارهای جدید و پارادایمهای ارزیابی پویا و جامعتری است که بتوانند کیفیت و کارایی LLMها را در سناریوهای پیچیدهتر به درستی سنجش کنند.

- مسائل تحقیقاتی باز (Open Research Questions): بنیادهای نظری مهندسی زمینه، مقیاسپذیری کارآمد (به ویژه از نظر محاسباتی)، یکپارچهسازی زمینه چندوجهی و ساختارمند، استقرار در دنیای واقعی، مسائل ایمنی، همراستایی و نگرانیهای اخلاقی، همچنان چالشهای تحقیقاتی باز و مهمی هستند که جامعه علمی باید به آنها بپردازد.

کاربردها و تأثیرات مهندسی زمینه

مهندسی زمینه، با فراهم آوردن قابلیتهای پیشرفته برای LLMها، تأثیر گستردهای در چندین حوزه کلیدی داشته است و به توسعه هوش مصنوعی قوی و سازگار با دامنه کمک میکند:

- پاسخگویی به سؤالات اسناد طولانی (Long-document/question answering): مهندسی زمینه مدلها را قادر میسازد تا از اسناد بسیار طولانی اطلاعات دقیق استخراج کنند و به سؤالات پیچیده پاسخ دهند. این امر برای کاربردهایی مانند بررسی حقوقی، تحلیل گزارشهای مالی و خلاصهسازی متون علمی بسیار ارزشمند است. با تکنیکهای مدیریت زمینه، LLMها میتوانند حتی با متنهایی که از پنجره زمینه معمول آنها فراتر میروند، به خوبی کار کنند.

- دستیاران دیجیتال شخصیسازیشده و عوامل هوشمند با حافظه (Personalized digital assistants and memory-augmented agents): با استفاده از سیستمهای حافظه و قابلیتهای بازیابی پیشرفته، دستیاران هوشمند میتوانند تاریخچه تعاملات کاربر را به خاطر بسپارند و پاسخهای شخصیسازیشده و مرتبطتری ارائه دهند. این امر منجر به تجربههای کاربری بهبود یافته و تعاملات طبیعیتر میشود، از برنامهریزی شخصی گرفته تا پشتیبانی مشتری.

- حل مسائل علمی، پزشکی و فنی (Scientific, medical, and technical problem-solving): مهندسی زمینه به LLMها امکان میدهد تا در حوزههای تخصصی به عنوان دستیاران تحقیقاتی عمل کنند. آنها میتوانند مقالات علمی را تحلیل کرده، فرضیهها را تولید کنند، دادههای پزشکی را تفسیر کرده و در حل مسائل فنی پیچیده کمک کنند. ادغام با ابزارهای خارجی، مانند سیستمهای شبیهسازی یا پایگاه دادههای بیولوژیکی، این قابلیتها را تقویت میکند.

- همکاری چند-عاملی در تجارت، آموزش و تحقیق (Multi-agent collaboration in business, education, and research): سیستمهای چند-عاملی مبتنی بر LLM میتوانند برای انجام وظایف پیچیده که نیاز به تخصصهای مختلف دارند، با یکدیگر همکاری کنند. به عنوان مثال، در یک محیط کسبوکار، عاملها میتوانند برای تدوین یک استراتژی بازاریابی، هر یک بر روی جنبهای خاص از بازار تمرکز کنند. در آموزش، آنها میتوانند به دانشآموزان در حل مسائل پیچیده کمک کنند و در تحقیق، به دانشمندان در بررسی دادههای بزرگ و تولید فرضیههای جدید یاری رسانند.

مسیرهای آینده

آینده مهندسی زمینه با چندین مسیر تحقیقاتی هیجانانگیز گره خورده است که پتانسیل تحول در قابلیتهای LLMها را دارند:

- نظریه یکپارچه (Unified Theory): توسعه چارچوبهای ریاضی و اطلاعاتی برای مهندسی زمینه، برای ایجاد یک درک عمیقتر از چگونگی عملکرد زمینه و بهینهسازی آن ضروری است. این نظریه میتواند به طراحی سیستمهای قویتر و قابل اعتمادتر منجر شود.

- مقیاسپذیری و کارایی (Scaling & Efficiency): نوآوریها در مکانیسمهای توجه و مدیریت حافظه برای پردازش حجم وسیعتر اطلاعات و افزایش کارایی محاسباتی LLMها حیاتی هستند. این شامل روشهایی برای کاهش هزینههای محاسباتی مربوط به توکنهای طولانی و حفظ عملکرد بالا در مقیاسپذیری بزرگ است.

- یکپارچهسازی چند-وجهی (Multi-Modal Integration): هماهنگی بیدرنگ متن، بینایی، صدا و دادههای ساختارمند به LLMها امکان میدهد تا درک جامعتری از دنیای واقعی داشته باشند و در کاربردهایی که نیاز به پردازش انواع مختلف اطلاعات دارند، عملکرد بهتری از خود نشان دهند. این امر به مدلها کمک میکند تا تعاملات غنیتر و طبیعیتری داشته باشند.

- استقرار قوی، ایمن و اخلاقی (Robust, Safe, and Ethical Deployment): اطمینان از قابلیت اطمینان، شفافیت و انصاف در سیستمهای مبتنی بر LLM که در دنیای واقعی مستقر میشوند، یک چالش بزرگ و حیاتی است. این شامل پرداختن به مسائل سوگیری، محافظت از حریم خصوصی و اطمینان از اینکه LLMها به طور مسئولانه و به نفع جامعه عمل میکنند، میشود.

خلاصه: مهندسی زمینه به عنوان رشتهای محوری برای هدایت نسل بعدی سیستمهای هوشمند مبتنی بر LLM در حال ظهور است، که تمرکز را از نوشتن خلاقانه پرامپت به علم دقیق بهینهسازی اطلاعات، طراحی سیستم و هوش مصنوعی مبتنی بر زمینه منتقل میکند.

منبع مقاله: A Technical Roadmap to Context Engineering in LLMs: Mechanisms, Benchmarks, and Open Challenges