التعلم المعزز وتحدياته في نماذج اللغات الكبيرة

يؤدي التعلم المعزز (RL) دورًا حيويًا في توسيع نطاق نماذج اللغات الكبيرة (LLM)، مما يمكّنها من حل المهام المعقدة مثل المسائل الرياضية على مستوى تنافسي والبرمجة من خلال التفكير الأعمق. هذه القدرات ضرورية للتقدم الجديد في الذكاء الاصطناعي. ومع ذلك، فإن تحقيق الاستقرار والموثوقية في ديناميكيات التدريب عند توسيع نطاق التعلم المعزز باستخدام موارد حوسبية أكبر يمثل تحديًا أساسيًا. تتطلب نماذج اللغات العملاقة، بسبب تعقيدها المتأصل وحجم البيانات الضخم، أساليب جديدة ومستقرة في عملية التعلم.

تعاني الخوارزميات المتقدمة الحالية، مثل GRPO، من مشكلات استقرار خطيرة أثناء تدريب نماذج اللغات الضخمة، مما يؤدي غالبًا إلى إخفاقات كارثية ولا رجعة فيها. تنجم هذه التقلبات عن التطبيق غير الصحيح لترجيح أخذ العينات الأهمية (Importance Sampling)، الذي يقدم ضوضاء ذات تباين عالٍ. تتراكم هذه الضوضاء مع إطالة الاستجابات وتتفاقم بفعل آليات الاقتصاص (Clipping). هذه المشكلة لا تؤدي فقط إلى انهيار النموذج، بل تعيق التقدم والاستفادة الكاملة من إمكانات نماذج اللغات الكبيرة.

يشير انهيار النموذج في الواقع إلى حالة يفقد فيها النموذج أداءه بسبب الضوضاء المفرطة أو الأهداف غير المتناسقة، ولم يعد بإمكانه أداء المهام الموكلة إليه بشكل صحيح. وهذا يعني إهدار الموارد الحاسوبية والوقت الطويل الذي استُهلك في تدريب النموذج. ونتيجة لذلك، هناك حاجة ماسة إلى خوارزميات يمكنها إدارة هذه الضوضاء بفعالية وضمان استقرار التدريب.

قيود الأساليب الحالية والحاجة إلى الابتكار

تعتمد الأساليب الحالية مثل PPO و GRPO على آليات مثل الاقتصاص (Clipping) لمواجهة تحديات التعلم خارج السياسة (Off-Policy Learning) حيث تُستمد الاستجابات من سياسات قديمة. تواجه هذه الأساليب قيودًا بسبب أهدافها غير المتناسقة، خاصة في النماذج الكبيرة التي تؤدي مهامًا تتطلب استجابات طويلة. يمكن لآلية الاقتصاص في هذه الخوارزميات، التي تُستخدم للحد من التقلبات، أن تصبح في بعض الأحيان عاملًا لعدم الاستقرار.

يُقدم أخذ العينات الأهمية على مستوى الرمز (Token-Level Importance Sampling) في GRPO ضوضاء ذات تباين عالٍ وانهيارًا لا رجعة فيه للنموذج. تفشل محاولات التعافي من الانهيار عبر ضبط المعلمات الفائقة أو استعادة نقاط التفتيش (Checkpoint Restoration)، مما يشير إلى عيب أساسي في التصميم. يؤكد عدم التوافق بين التصحيحات على مستوى الرمز والمكافآت على مستوى التسلسل الحاجة إلى نهج جديد يُحسن الأداء مباشرة على مستوى التسلسل لضمان الاستقرار وقابلية التوسع. وقد دفع هذا الأمر الباحثين نحو استكشاف حلول جديدة.

تشير هذه النواقص إلى أنه على الرغم من فعالية GRPO في بعض السيناريوهات، إلا أنها غير مناسبة لنموذج اللغة الكبيرة التي تنتج مخرجات طويلة ومعقدة. يمكن أن تؤدي التغييرات الصغيرة في تقدير التدرج على مستوى الرمز إلى انحرافات كبيرة في التسلسل بأكمله، وتتراكم هذه الانحرافات بمرور الوقت وتوجه النموذج نحو حالة غير مرغوب فيها.

تقديم تحسين سياسة التسلسل الجماعي (GSPO)

اقترح باحثون من شركة Alibaba Inc. خوارزمية GSPO (تحسين سياسة التسلسل الجماعي)، وهي خوارزمية تعلّم تعزيزي مصممة لتدريب نماذج اللغات الكبيرة (LLM). يكمن الابتكار الرئيسي لـ GSPO في نسبة الأهمية الخاصة بها، والتي تُشتق نظريًا من احتمالية التسلسل (Sequence Likelihood) وتتفق مع مبادئ أخذ العينات الأهمية. يوفر هذا النهج أساسًا نظريًا قويًا لإدارة الضوضاء في عملية التعلم.

بالإضافة إلى ذلك، تحسب GSPO المكافآت المُطَبَّعة كفوائد لاستجابات متعددة لسؤال واحد، مما يعزز التوافق بين مكافآت مستوى التسلسل وأهداف التحسين. هذا التوافق هو المفتاح لتحقيق استقرار أكبر وأداء أفضل أثناء التدريب. من خلال التحسين على مستوى التسلسل، تتجنب GSPO المشاكل الناجمة عن التصحيحات المتفرقة والضوضائية على مستوى الرمز.

تُظهر التقييمات التجريبية أن GSPO تتفوق بشكل ملحوظ على GRPO في الاستقرار والكفاءة والأداء العام. من خلال حل تحديات الاستقرار في تدريب نماذج Mixture-of-Experts (MoE) الكبيرة، تزيل GSPO الحاجة إلى تقنيات تثبيت معقدة. وهذا لا يبسط عملية التدريب فحسب، بل يتيح الاستفادة الكاملة من قدرات هذه النماذج المتقدمة. تُشير النتائج إلى أن GSPO يمكنها تمهيد الطريق لنموذج لغات كبير (LLM) أقوى وأكثر كفاءة.

التحقق التجريبي وفعالية GSPO

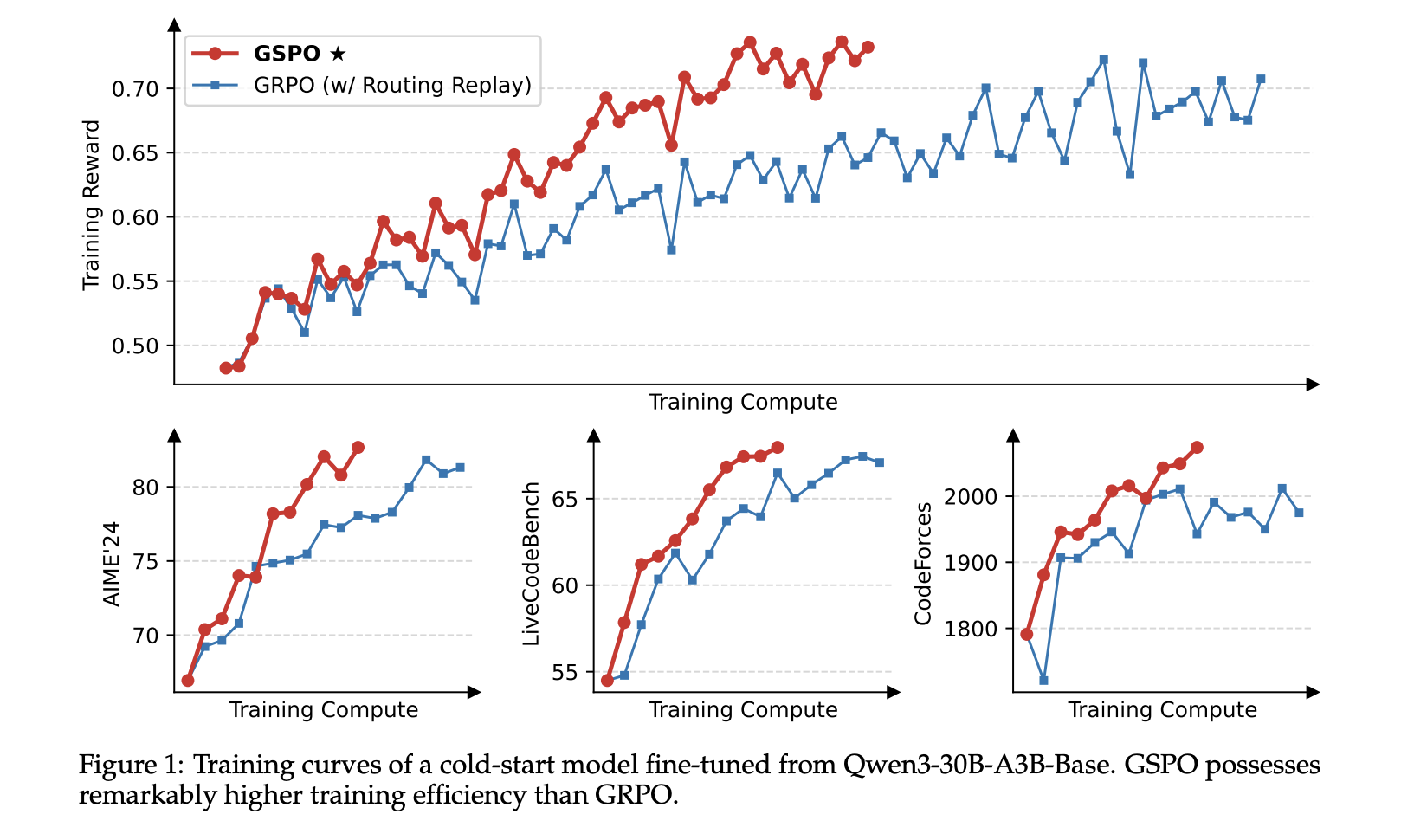

استخدم الباحثون نموذجًا بدأ من الصفر (Cold-Start Model) الذي تم تحسينه من Qwen3-30B-A3B-Base لتجاربهم. وقاموا بالإبلاغ عن منحنيات مكافأة التدريب ومنحنيات أداء النموذج في معايير AIME’24 وLiveCodeBench وCodeForces. تتضمن هذه المعايير مهام رياضية وبرمجية معقدة تقيس قدرة النموذج على الاستدلال العميق وحل المشكلات.

أثناء التدريب، تم تقسيم بيانات التنفيذ (Rollout Data) في كل دفعة (Batch) إلى أربع دفعات صغيرة (Mini-Batches) لتحديث التدرجات. يتيح هذا الأسلوب التحسيني ضبطًا أدق للأوزان وتحسين جودة التدريب. يُعد النهج الدقيق في إدارة التدرجات أمرًا بالغ الأهمية للحفاظ على الاستقرار في النماذج الكبيرة، حيث أن أدنى خطأ يمكن أن يؤدي إلى انحرافات كبيرة.

يقوم GSPO باقتصاص الاستجابات بأكملها بدلاً من الرموز الفردية، مع ضبط نطاقات الاقتصاص على 3e-4 و 4e-4 في صياغتها. يؤدي هذا إلى فرق في حجمين من حيث نسبة الرموز المقتصة مقارنة بـ GRPO. على الرغم من إزالة المزيد من الرموز لتقدير التدرج، يحقق GSPO كفاءة تدريبية أعلى. تؤكد هذه النتيجة على عدم كفاءة تقديرات الضوضاء على مستوى الرمز في GRPO وتوضح أن جودة الاقتصاص أكثر أهمية من كميته.

مزايا GSPO لتدريب نماذج MoE وبنية التعلم المعزز التحتية

تقدم GSPO مزايا كبيرة لتدريب نماذج Mixture-of-Experts (MoE) من خلال ضمان تنشيط مستقر للخبراء أثناء تحديثات التدرج، على عكس GRPO التي تعاني من تقلبات في تنشيط الخبراء. يتيح هذا الاستقرار لنموذج MoE استغلال إمكاناته الكاملة وتبسيط عملية التدريب دون الحاجة إلى حلول معقدة مثل Routing Replay.

في البنية التحتية للتعلم المعزز (RL)، يقلل تحسين GSPO على مستوى التسلسل من الاعتماد على الاحتمالات على مستوى الرمز ويجعله أكثر مقاومة لعدم تطابق الدقة (Precision Mismatch). تعني هذه الإمكانية القدرة على استخدام احتمالات محرك الاستدلال (Inference Engine Likelihoods) مباشرة، مما يمنع إعادة الحسابات المكلفة ويحسن الكفاءة في عمليات التنفيذ الجزئية (Partial Rollouts) والتعلم المعزز متعدد الدورات (Multi-Turn RL).

تبسط GSPO أيضًا البنية التحتية للتعلم المعزز لتدريب نماذج اللغات على نطاق واسع. يؤدي هذا التبسيط إلى تقليل التعقيد التشغيلي وزيادة قابلية التوسع الكلية للنظام. من خلال توفير منصة أكثر استقرارًا وكفاءة، تسهل GSPO تطوير ونشر نماذج اللغات الكبيرة القوية لمختلف التطبيقات وتسمح للباحثين بالتركيز على الابتكار في جوانب أخرى من الذكاء الاصطناعي.

الخلاصة وآفاق المستقبل

في الختام، قدم الباحثون خوارزمية تحسين سياسة التسلسل الجماعي (GSPO)، وهي خوارزمية تعلّم تعزيزي لتدريب نماذج اللغات الكبيرة (LLM). تعتمد GSPO على مبادئ أخذ العينات الأهمية وتقدم آليات الاقتصاص والمكافأة والتحسين على مستوى التسلسل للتغلب على مشاكل عدم الاستقرار وعدم الكفاءة الملاحظة في خوارزمية GRPO. يمهد هذا النهج الجديد الطريق لتدريب نماذج اللغات الكبيرة بشكل أكثر استقرارًا وكفاءة، ويحمل إمكانات هائلة للتقدم المستقبلي في الذكاء الاصطناعي.

يُشدد الأداء المتفوق لـ GSPO في الاستقرار والكفاءة وقابلية التوسع في التدريب، خاصة بالنسبة لنماذج Mixture-of-Experts (MoE)، على أهميتها كأساس خوارزمي قوي. باستخدام GSPO، يمكن تدريب نماذج أكثر تعقيدًا بثقة أكبر، مما يؤدي إلى زيادة قدرتها على أداء المهام الصعبة. هذه التطورات ستؤتي ثمارها الإيجابية ليس فقط في مجال البحث، بل في التطبيقات العملية أيضًا.

لقد لعبت التطورات التي أتاحتها GSPO دورًا رئيسيًا في الأداء المذهل لنماذج Qwen3. بفضل استخدام هذه الخوارزمية المبتكرة، تمكنت هذه النماذج من تحقيق مستويات جديدة من الدقة والكفاءة. بناءً على GSPO كنهج أساسي، يخطط الباحثون لتوسيع أساليب التعلم المعزز، وهذا يفتح الباب أمام تطورات تحويلية في الذكاء الاصطناعي. يبدو مستقبل نماذج اللغات الكبيرة أكثر إشراقًا من أي وقت مضى مع خوارزميات مثل GSPO.

للمزيد من القراءة، يُرجى الرجوع إلى المقال الأصلي: https://arxiv.org/abs/2507.18071