یادگیری تقویتی و چالشهای آن در مدلهای زبانی بزرگ

یادگیری تقویتی (RL) نقش حیاتی در مقیاسبندی مدلهای زبانی بزرگ (LLM) ایفا میکند و آنها را قادر میسازد تا از طریق استدلال عمیقتر، وظایف پیچیدهای مانند مسائل ریاضی در سطح رقابتی و برنامهنویسی را حل کنند. این قابلیتها برای پیشرفتهای نوین در هوش مصنوعی ضروری هستند. با این حال، دستیابی به پایداری و اطمینان در دینامیکهای آموزشی هنگام مقیاسبندی RL با منابع محاسباتی بزرگتر، یک چالش اساسی است. مدلهای زبانی غولپیکر به دلیل پیچیدگی ذاتی و حجم دادههای عظیم، نیازمند رویکردهای نوین و پایداری در فرآیند یادگیری هستند.

الگوریتمهای پیشرفته کنونی، مانند GRPO، با مشکلات جدی پایداری در طول آموزش مدلهای زبانی عظیم دست و پنجه نرم میکنند که اغلب منجر به شکستهای فاجعهبار و غیرقابل برگشت میشوند. این ناپایداریها از کاربرد نادرست وزندهی نمونهبرداری اهمیت (Importance Sampling) ناشی میشوند که نویز با واریانس بالا را معرفی میکنند. این نویز با طولانیتر شدن پاسخها انباشته میشود و با مکانیسمهای برش (Clipping) تشدید میگردد. این مسئله نه تنها به فروپاشی مدل منجر میشود، بلکه مانع پیشرفت و بهرهبرداری کامل از پتانسیل LLMها میگردد.

فروپاشی مدل در واقع به وضعیتی اشاره دارد که در آن مدل به دلیل نویزهای زیاد یا اهداف ناسازگار، عملکرد خود را از دست داده و دیگر نمیتواند وظایف محوله را به درستی انجام دهد. این امر به معنای هدر رفتن منابع محاسباتی و زمان زیادی است که صرف آموزش مدل شده است. در نتیجه، نیاز به الگوریتمهایی که بتوانند این نویز را به طور موثر مدیریت کرده و پایداری آموزش را تضمین کنند، به شدت احساس میشود.

محدودیتهای رویکردهای موجود و نیاز به نوآوری

روشهای موجود مانند PPO و GRPO برای مقابله با چالشهای یادگیری خارج از سیاست (Off-Policy Learning) که در آن پاسخها از سیاستهای منسوخ شده گرفته میشوند، به مکانیسمهایی مانند برش (Clipping) متکی هستند. این رویکردها به دلیل اهداف ناسازگارشان، به ویژه در مدلهای بزرگ که وظایف با پاسخهای طولانی را انجام میدهند، با محدودیتهایی مواجهاند. مکانیزم برش در این الگوریتمها، که برای محدود کردن نوسانات به کار میرود، گاهی اوقات میتواند خود به عاملی برای ناپایداری تبدیل شود.

نمونهبرداری اهمیت در سطح توکن (Token-Level Importance Sampling) در GRPO، نویز با واریانس بالا و فروپاشی غیرقابل برگشت مدل را معرفی میکند. تلاش برای بازیابی از فروپاشی از طریق تنظیم ابرپارامترها یا بازیابی نقاط بازرسی (Checkpoint Restoration) با شکست مواجه میشود، که نشاندهنده یک نقص اساسی در طراحی است. عدم تطابق بین تصحیحات در سطح توکن و پاداشها در سطح توالی، بر نیاز به یک رویکرد جدید که مستقیماً در سطح توالی بهینهسازی میکند، تأکید میکند تا پایداری و مقیاسپذیری تضمین شود. این مسئله، پژوهشگران را به سمت بررسی راهکارهای جدید سوق داده است.

این نارساییها به این معنی است که هرچند GRPO در برخی سناریوها کارآمد است، اما برای مدلهای زبانی بزرگ که خروجیهای طولانی و پیچیده تولید میکنند، مناسب نیست. تغییرات کوچک در تخمین گرادیان در سطح توکن میتواند به انحرافات بزرگی در کل توالی منجر شود، و این انحرافات به مرور زمان انباشته شده و مدل را به سمت یک وضعیت نامطلوب هدایت میکنند.

معرفی بهینهسازی سیاست توالی گروهی (GSPO)

پژوهشگران از شرکت Alibaba Inc.، الگوریتم GSPO (Group Sequence Policy Optimization) را پیشنهاد کردهاند، که یک الگوریتم یادگیری تقویتی است که برای آموزش LLMها طراحی شده است. نوآوری اصلی GSPO در نسبت اهمیت آن است که به صورت نظری از احتمال توالی (Sequence Likelihood) استخراج شده و با اصول نمونهبرداری اهمیت هماهنگ است. این رویکرد، یک پایه نظری قوی برای مدیریت نویز در فرآیند یادگیری فراهم میکند.

علاوه بر این، GSPO پاداشهای نرمالشده را به عنوان مزایایی برای پاسخهای متعدد به یک پرسش محاسبه میکند، که سازگاری بین پاداشهای سطح توالی و اهداف بهینهسازی را ترویج میدهد. این سازگاری، کلید دستیابی به پایداری بیشتر و عملکرد بهتر در طول آموزش است. با بهینهسازی در سطح توالی، GSPO از مشکلات ناشی از تصحیحات پراکنده و نویزدار در سطح توکن جلوگیری میکند.

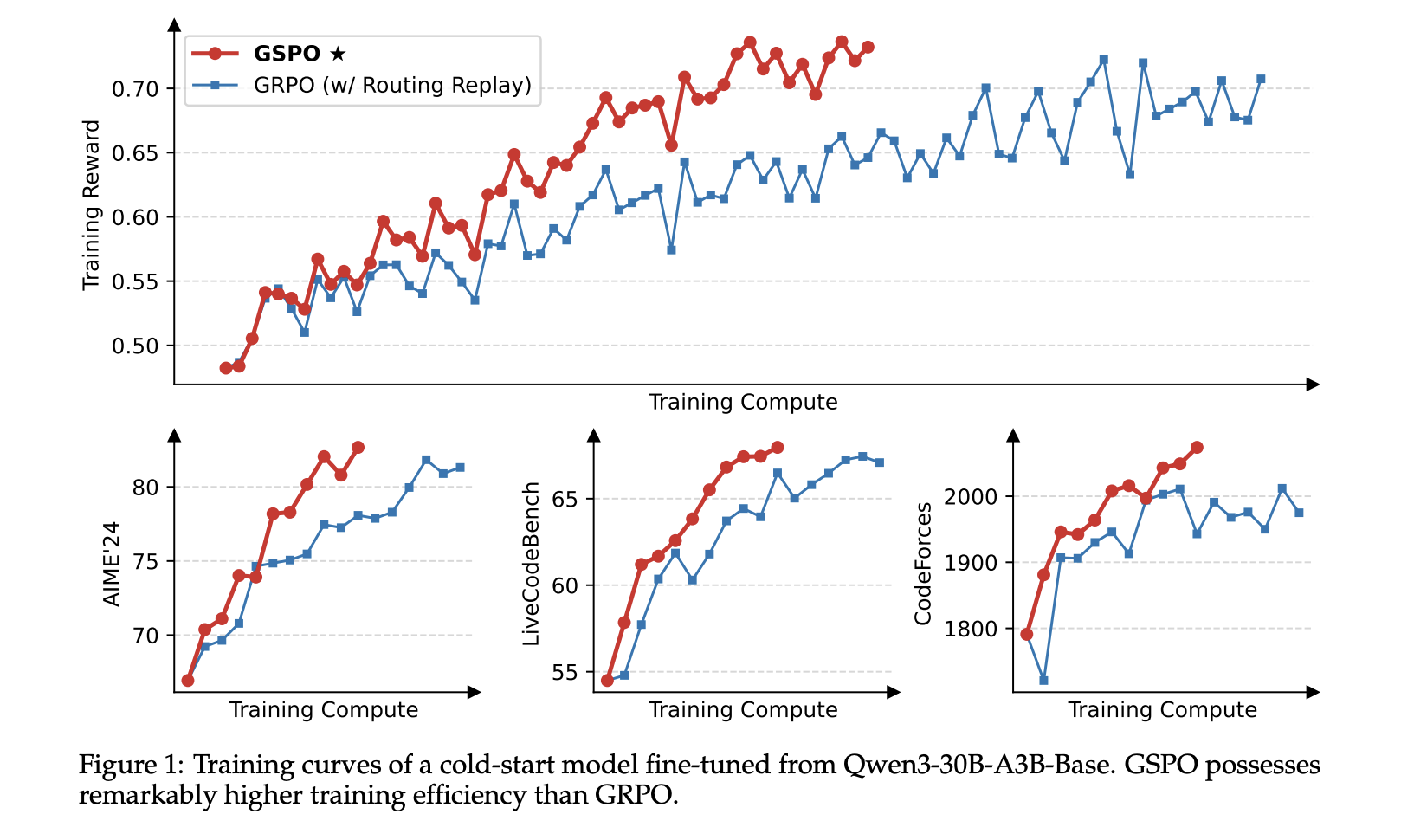

ارزیابیهای تجربی نشان میدهد که GSPO به طور قابل توجهی از GRPO در پایداری، کارایی و عملکرد کلی بهتر عمل میکند. با حل چالشهای پایداری در آموزش مدلهای بزرگ Mixture-of-Experts (MoE)، GSPO نیاز به تکنیکهای پیچیده تثبیت را از بین میبرد. این امر نه تنها فرآیند آموزش را ساده میکند، بلکه امکان بهرهبرداری کامل از قابلیتهای این مدلهای پیشرفته را فراهم میآورد. نتایج نشان میدهد که GSPO میتواند مسیر را برای LLMهای قویتر و کارآمدتر هموار کند.

اعتبار سنجی تجربی و کارایی GSPO

پژوهشگران از یک مدل سرد شروع (Cold-Start Model) که از Qwen3-30B-A3B-Base برای آزمایش خود بهینهسازی شده بود، استفاده کردند. آنها منحنیهای پاداش آموزش و منحنیهای عملکرد مدل را در بنچمارکهای AIME’24، LiveCodeBench و CodeForces گزارش کردند. این بنچمارکها شامل وظایف پیچیده ریاضی و برنامهنویسی هستند که توانایی مدل را در استدلال عمیق و حل مسئله میسنجند.

در طول آموزش، دادههای حاصل از هر بار اجرا (Rollout Data) در هر دسته (Batch) به چهار دستهی کوچک (Mini-Batches) برای بهروزرسانی گرادیانها تقسیم شدند. این روش بهینهسازی، امکان تنظیم دقیقتر وزنها و بهبود کیفیت آموزش را فراهم میکند. رویکرد دقیق در مدیریت گرادیانها برای حفظ پایداری در مدلهای بزرگ بسیار مهم است، چرا که کوچکترین خطا میتواند به انحرافات بزرگی منجر شود.

GSPO به جای توکنهای جداگانه، کل پاسخها را برش میدهد، با محدودههای برش تنظیمشده روی 3e-4 و 4e-4 در فرمولاسیون آن. این امر منجر به تفاوت دو مرتبه بزرگی در نسبت توکنهای برشخورده در مقایسه با GRPO میشود. با وجود حذف توکنهای بیشتر برای تخمین گرادیان، GSPO به کارایی آموزشی بالاتری دست مییابد. این نتیجه بر ناکارآمدی تخمینهای نویزدار در سطح توکن GRPO تأکید میکند و نشان میدهد که کیفیت برشدهی اهمیت بیشتری نسبت به کمیت آن دارد.

مزایای GSPO برای آموزش مدلهای MoE و زیرساخت RL

GSPO با تضمین فعالسازیهای پایدار متخصصان در طول بهروزرسانیهای گرادیان، مزایای قابل توجهی برای آموزش مدلهای Mixture-of-Experts (MoE) ارائه میدهد، بر خلاف GRPO که با نوسانات فعالسازی متخصصان دست و پنجه نرم میکند. این پایداری به مدلهای MoE اجازه میدهد تا از پتانسیل کامل خود بهرهبرداری کرده و بدون نیاز به راهحلهای پیچیده مانند Routing Replay، فرآیند آموزش را سادهسازی کنند.

در زیرساخت یادگیری تقویتی (RL)، بهینهسازی در سطح توالی GSPO، وابستگی به احتمالات در سطح توکن را کاهش میدهد و آن را در برابر عدم تطابق دقت (Precision Mismatch) مقاومتر میسازد. این قابلیت به معنای امکان استفاده مستقیم از احتمالات موتور استنتاج (Inference Engine Likelihoods) است، که از محاسبات مجدد پرهزینه جلوگیری میکند و کارایی را در رولآوتهای جزئی (Partial Rollouts) و RL چند مرحلهای (Multi-Turn RL) بهبود میبخشد.

GSPO همچنین زیرساخت RL را برای آموزش مدلهای زبانی در مقیاس بزرگ سادهتر میکند. این سادهسازی منجر به کاهش پیچیدگی عملیاتی و افزایش مقیاسپذیری کلی سیستم میشود. با فراهم آوردن یک بستر پایدارتر و کارآمدتر، GSPO توسعه و استقرار LLMهای قدرتمند را برای کاربردهای مختلف تسهیل میبخشد و به پژوهشگران اجازه میدهد تا بر نوآوری در جنبههای دیگر هوش مصنوعی تمرکز کنند.

نتیجهگیری و چشمانداز آینده

در نتیجه، پژوهشگران الگوریتم بهینهسازی سیاست توالی گروهی (GSPO) را معرفی کردهاند که یک الگوریتم یادگیری تقویتی برای آموزش مدلهای زبانی بزرگ (LLM) است. GSPO بر اصول نمونهبرداری اهمیت بنا شده و مکانیسمهای برش، پاداشدهی و بهینهسازی در سطح توالی را معرفی میکند تا بر مشکلات ناپایداری و ناکارآمدی مشاهده شده در الگوریتم GRPO غلبه کند. این رویکرد جدید، راه را برای آموزش پایدارتر و کارآمدتر LLMها هموار میکند و پتانسیل عظیمی برای پیشرفتهای آینده در هوش مصنوعی دارد.

عملکرد برتر GSPO در پایداری، کارایی و مقیاسپذیری آموزش، به ویژه برای مدلهای Mixture-of-Experts (MoE)، بر اهمیت آن به عنوان یک بنیان الگوریتمی قوی تأکید میکند. با استفاده از GSPO، میتوان مدلهای پیچیدهتری را با اطمینان بیشتری آموزش داد، که منجر به افزایش توانایی آنها در انجام وظایف دشوار میشود. این پیشرفتها نه تنها در حوزه پژوهش، بلکه در کاربردهای عملی نیز نتایج مثبتی به همراه خواهند داشت.

پیشرفتهای ممکن شده توسط GSPO نقش کلیدی در عملکرد چشمگیر مدلهای Qwen3 ایفا کردهاند. این مدلها به دلیل استفاده از این الگوریتم نوآورانه، قادر به دستیابی به سطوح جدیدی از دقت و کارایی شدهاند. بر اساس GSPO به عنوان یک رویکرد بنیادی، پژوهشگران قصد دارند روشهای یادگیری تقویتی را گسترش دهند، و این امر در را برای پیشرفتهای دگرگونکننده در هوش مصنوعی باز میکند. آیندهی LLMها با الگوریتمهایی نظیر GSPO روشنتر از همیشه به نظر میرسد.

برای مطالعه بیشتر، به مقاله اصلی مراجعه کنید: https://arxiv.org/abs/2507.18071